Привет читатели seoslim.ru! С появлением нейросетей и генеративных моделей, таких как ChatGPT, многие начали массово использовать AI-контент для наполнения сайтов, блогов и маркетинговых материалов.

Это удобно, быстро и дешево. Однако вместе с ростом популярности искусственного интеллекта усилилось и внимание поисковых систем (особенно Google) к качеству таких текстов.

Гугл не запрещает использовать AI-генераторы напрямую, но активно борется с низкокачественным, шаблонным или созданным исключительно ради продвижения контентом. Если сайт начинает злоупотреблять машинными публикациями, он рискует попасть под фильтры, теряя трафик, позиции и доверие.

Далее разберём, как мировой поисковик действительно реагирует на AI-контент, какие виды текстов попадают под санкции, и как создавать такие материалы с помощью нейросетей, чтобы они не только не вредили, но и приносили пользу.

Как Google распознаёт и оценивает ИИ-контент

Гугл официально не запрещает использование искусственного интеллекта при создании текстов. Однако ключевым критерием для поисковика остаётся качество контента, а не способ его генерации.

Это подтверждается в документации Search Central, где говорится, что AI-материалы не нарушают правила, если они полезны для пользователя и созданы с упором на E-E-A-T (опыт, экспертиза, авторитетность, надёжность).

Тем не менее, Google активно совершенствует алгоритмы, способные отличать машинные тексты от человеческих.

Это происходит за счёт:

- анализа структуры и повторяющихся шаблонов фраз;

- оценки логики, достоверности и уникальности информации;

- сравнения с другими источниками;

- изучения поведения пользователей (время на странице, возвраты, вовлечённость).

Наибольший риск возникает, если AI-контент размещается в больших объёмах без редактуры, используется исключительно для генерации SEO-текстов с ключевыми словами, не несёт фактической пользы, а так же состоит из «воды» и общих фраз.

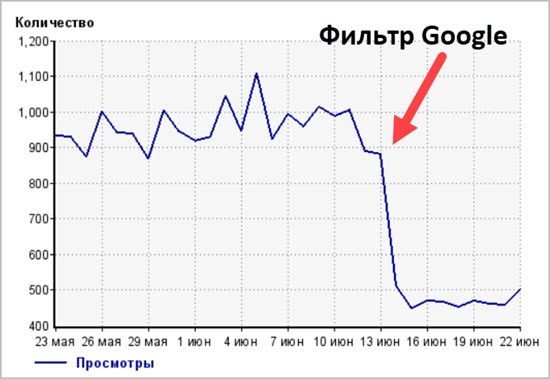

Результат — снижение позиций в выдаче, попадание под фильтры Google Helpful Content или даже полное исключение страниц из индекса.

За что поисковая система может отправить сайт под фильтр

Хотя Google не карает напрямую за сам факт использования AI, он активно борется с попытками манипулировать поисковой выдачей с помощью некачественного контента.

Это значит, что наказание наступает не за сам инструмент, а за способ его применения. Ниже — основные причины, по которым сайт может попасть под санкции:

- Контент, созданный исключительно ради SEO.

Если текст представляет собой бессмысленную смесь ключевых слов, шаблонных фраз и воды — без пользы для читателя — он расценивается как «low-value content». Даже если он сгенерирован нейросетью, Google отследит это и понизит такие страницы.

- Массовая публикация одинаковых материалов.

Когда ИИ используется для создания десятков или сотен страниц с почти идентичной структурой, содержанием и логикой, поисковик распознаёт это как спам. Особенно если такие материалы не имеют авторов, источников и не адаптированы под аудиторию.

- Отсутствие признаков человеческой доработки.

Необработанные тексты, в которых видны повторения, странные формулировки или ошибки в логике, выдают машинное происхождение. Такие статьи быстро теряют позиции или даже не индексируются вовсе.

- Сайты, сделанные под монетизацию AI-контента.

Google уже распознаёт проекты, создаваемые с единственной целью — быстро зарабатывать на рекламе с помощью потоковой генерации материалов. Эти сайты могут попасть под фильтр SpamBrain, обновлённый в 2023–2024 годах с акцентом на борьбу с AI-спамом.

- Игнорирование принципов E-E-A-T.

Если контент не демонстрирует экспертности, практического опыта, авторской позиции и достоверности источников — он воспринимается как подозрительный, даже если формально написан грамотно.

Важно! санкции не всегда выражаются в виде полного исключения из поисковой системы. Чаще — это постепенное снижение позиций, падение трафика и утрата доверия к ресурсу со стороны алгоритма Google.

Как использовать AI-контент без риска для сайта

Чтобы избежать проблем с поисковыми алгоритмами и использовать возможности искусственного интеллекта во благо сайта, важно следовать ряду принципов.

Речь не о полном отказе от нейросетей, а о умном, контролируемом и качественном подходе к их применению.

Делайте ставку на ценность для читателя. Каждый текст должен решать конкретную задачу: обучать, объяснять, помогать, вдохновлять. Прежде чем публиковать материал, спросите себя — получит ли читатель пользу от прочтения? Если нет — Google тоже этого не оценит.

Всегда редактируйте и дорабатывайте AI-текст. Нейросеть может быть основой, черновиком или помощником. Но финальная версия текста должна проходить через руки человека: вычищать штампы, уточнять детали, корректировать факты и адаптировать стиль.

Добавляйте человеческий опыт (E-E-A-T). Идеально, если в тексте есть личный опыт, отзывы, ссылки на авторитетные источники, мнения специалистов. Такие элементы сразу повышают доверие к материалу — и у пользователей, и у поисковиков.

Используйте AI как инструмент, а не как фабрику контента. Нейросеть хороша в генерации черновиков, заголовков, структуры, резюме, описаний товаров и однотипных задач. Но не стоит ей доверять создание экспертных обзоров, аналитических статей или материалов по чувствительным темам (медицина, финансы).

Публикуйте от имени реальных авторов. Контент должен быть подписан, желательно — специалистом в теме. Это укрепляет E-E-A-T и снижает риск того, что Google воспримет сайт как «безликую AI-помойку».

Следите за уникальностью и логикой. Даже нейросети могут повторяться. Используйте антиплагиат, перепроверяйте выводы и убедитесь, что статья не дублирует другие публикации на вашем сайте.

Следуя этим рекомендациям, можно безопасно использовать ИИ и при этом создавать качественный, интересный и полезный контент, который не попадёт под фильтры Google, а наоборот — получит высокую оценку в выдаче.