Привет уважаемые читатели seoslim.ru! Если вы занимаетесь созданием и продвижением сайтов, то этот пост будет вам полезен.

Так как каждый из вебмастеров хочет видеть свои и клиентские проекты на первых местах поисковой выдачи, поэтому нередко приходится проводить технический аудит сайта с целью выяснить и устранить все имеющиеся seo-ошибки, дубли страниц, мета-данные, ссылки, редиректы и прочее.

Кто-то для этого привык использовать онлайн сервисы, благо выбрать есть из чего, одним из популярных является Serpstat, и все бы там хорошо, но в бесплатном режиме он имеет ограничения на количество запросов, чего не скажешь о десктопной программе Netpeak Spider, которую мы и будем тестировать ниже.

Да, онлайн сервисы — это удобно, ты не привязан к компьютеру и в любом месте можешь получить данные по сайту даже с мобильного устройства, однако, не все они могут похвастаться тем функционалом, который есть у программы, пусть и установленной на жесткий диск вашего ПК.

Что умеет Netpeak Spider

Если вы не первый день развиваете сайты, то слышали про крупнейшее агентство интернет-маркетинга Netpeak, у которого несколько тысяч проектов.

В Netpeak Group входит компания Netpeak Software, которая занимается созданием инструментов для интернет-маркетологов. Сегодня seo-специалисты и вебмастера могут воспользоваться такими приложениями как Netpeak Spider и Netpeak Checker, о последнем я расскажу в следующих статьях, а сейчас на интересует аудит и оптимизация сайта.

Netpeak Spider — это программа сканер-сайтов, просканирует любую площадку с открытым доступом и выявит все seo ошибки, которые могут оказать влияние как на работу, так и ранжирование площадки в поисковой выдаче.

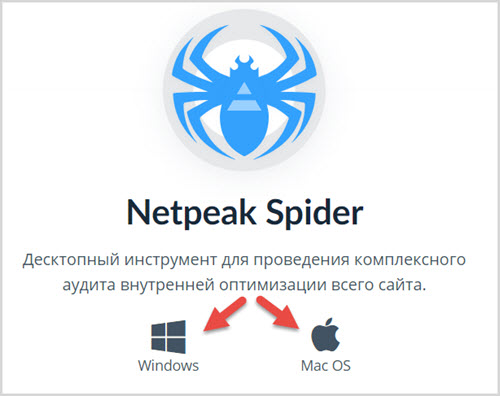

Сразу отмечу, что данный софт поддерживает работу на ОС Windows и MAC OS, а вот Linux пока еще находится в разработке.

Список задач, которые решает Нетпик Спайдер:

- Проверка SEO-параметров.

- Определение ошибок внутренней оптимизации.

- Анализ ссылочной массы (входящие и исходящие внутренние линки).

- Поиск битые ссылок и редиректов.

- Поиск дублей страниц, заголовков title и h1, метаданных, описания.

- Расчет PageRank для внутренних страниц.

- Настойка правил сканирования сайта.

- Экспорт всех данных.

Заявлено, что программа при анализе учитывает 54 параметра и может выявить до 62 ошибок, вот это мы сейчас и проверим.

Как сделать аудит сайта и найти все ошибки

Первое что надо сделать, это установить данный софт на свой ПК. Делается это просто, вот только надо сперва пройти регистрации и только потом скачать Launcher.

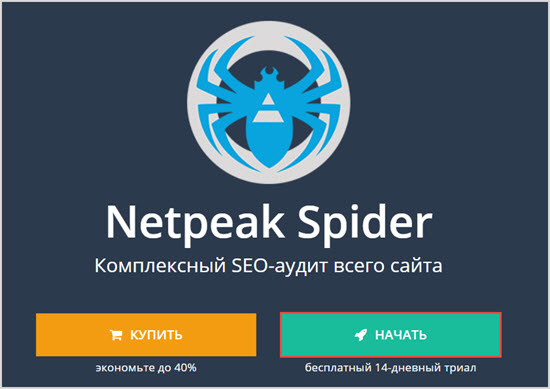

Переходим на официальный сайт Netpeak Software и выбираем нужный продукт, либо же делаем это по указанной ссылке netpeaksoftware.com/ru/spider после этого жмем кнопку «Начать» дабы воспользоваться программой бесплатно.

Обратите внимание! Netpeak Spider имеет бесплатную версию, в которой доступен практически весь функционал без ограничений по времени использования, количеству URL и с возможностью кастомизации настроек.

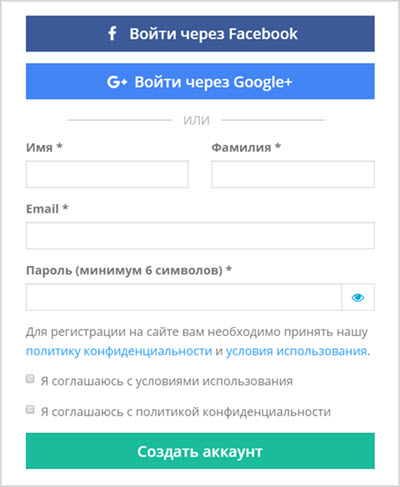

После этого заполняем стандартные поля формы регистрации или используем социальные сети Facebook или Google+.

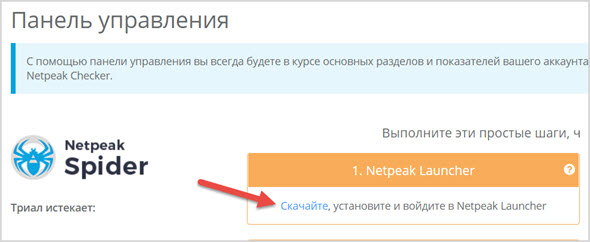

На следующем этапе после регистрации переходим в панель управления и скачиваем и устанавливаем приложение.

Для синхронизации программы с ПК введите ваш логин и пароль от учетной записи созданного ранее аккаунта.

Итак, с установкой разобрались теперь переходим к самому интересному — анализ сайта.

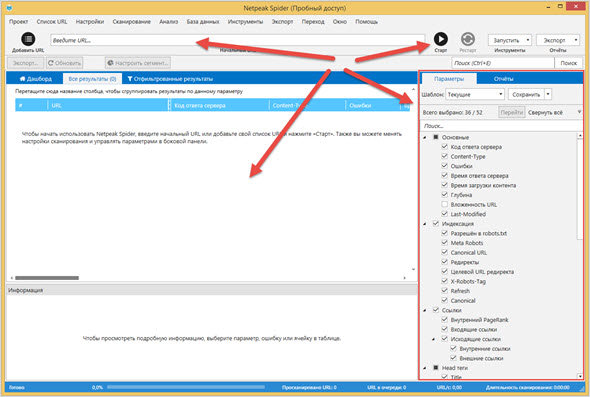

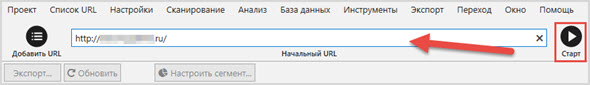

Для этого запускаем софт и видим окно, в котором все разделено по категориям. Сразу понятно, куда надо прописывать сайт, где будет представлен отчет и по каким параметрам будет проходить анализ.

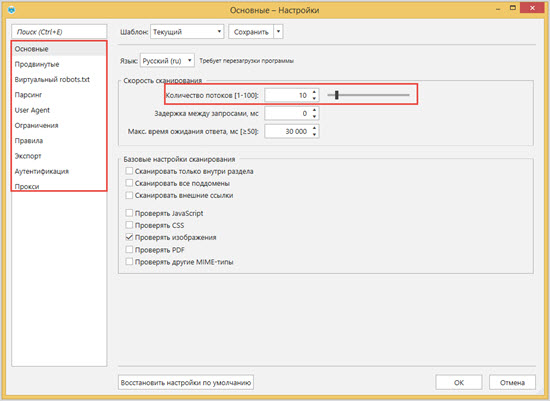

Лично мне хватает дефолтных настроек, но если у вас очень медленный интернет, слабое железо или сайт размещен на дешевом хостинге, тогда можно уменьшить количество поток.

Думаю, вы прекрасно понимаете, что чем их больше, тем больше идет запросов к серверу, где размещен сайт и он просто может «лечь».

Если вы хотите собрать более полную картину по сайту, тогда отключите галочку Canonical, чтобы проанализировать все имеющиеся URL.

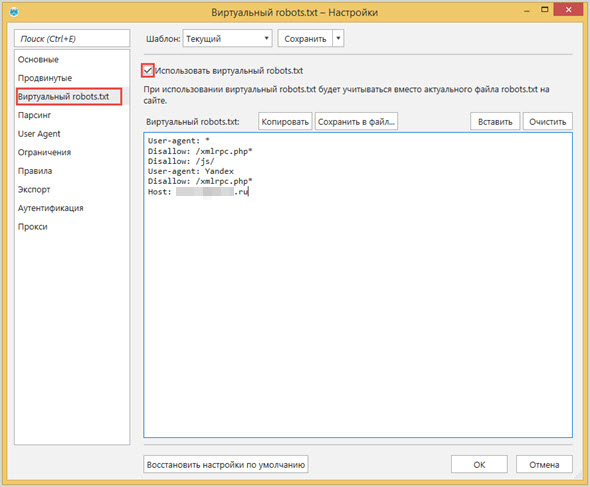

Новой функцией является виртуальный robots.txt, где можно протестировать файл, который вы еще не загрузили в сеть, чтобы понять, как он будет влиять на сканирование площадки роботами поисковых систем.

Здесь же можно добавить правила и ограничения, формат экспорта файлов, прокси и много других настроек.

Однако на первом этапе пользования программой не вижу смысла вникать во все тонкости, поэтому давайте перейдем непосредственно к сканированию проекта.

Достаточно ввести его URL адрес в специальное поле, нажать «Старт» и подождать, когда будет окончен сбор данных.

На сканирование сайта, у которого почти 1000 страниц в индексе Яндекс, при 10 потоках понадобилось 14 минут. Для тех, кто будет анализировать не один сайт, лучше количество потоков увеличить.

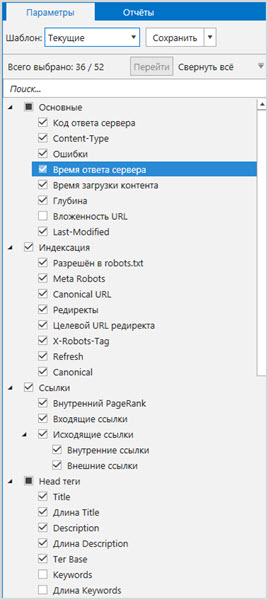

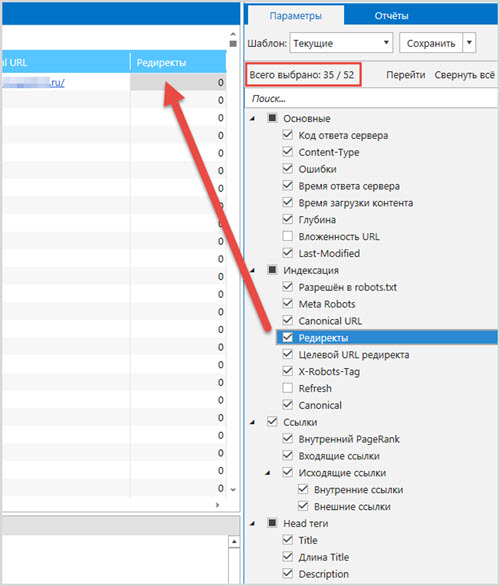

Как вариант перед анализом можно отключить ненужные вам параметры, чтобы Netpeak Spider на это не тратила время, а вы на них не отвлекались в отчетах.

Все приходит с опытом, лично мне 52 параметра не надо, а в будущем оставлю для себя десяток наиболее важных.

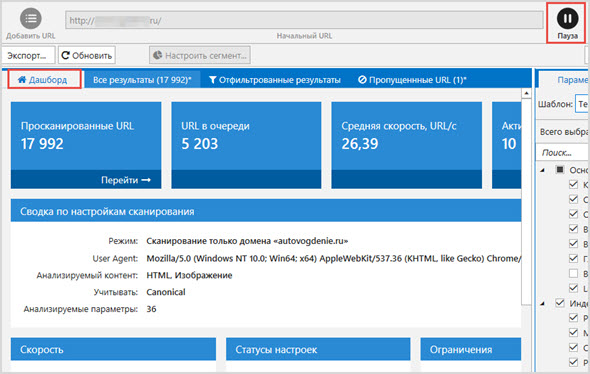

Кстати, в любой момент вы можете поставить сканирование на паузу и продолжить его в любой другой момент с того места, где была произведена остановка.

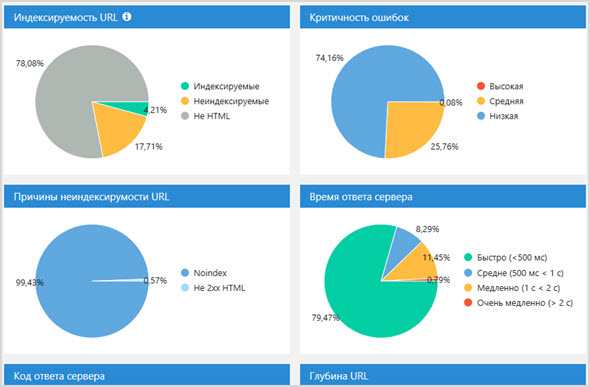

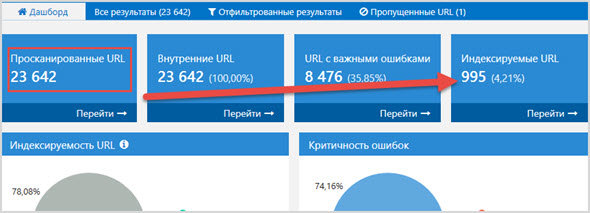

После окончания парсинга или постановки его на паузу во вкладке «Дашборд» отображается общее число просканированных адресов с графиками и диаграммами.

Можно не переходить к вкладке «Результаты» и с ходу понять сколько ошибок имеется на сайте, есть ли проблемы с сервером, индексируемостью.

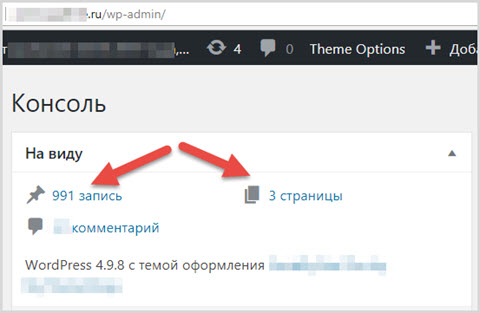

Дашборд показал, что на сканируемом сайте из тысяч страниц, для индексации поисковиками открыты только 995, вместе с главной.

Если перейти в админ панель движка сайта, то это значение совпадает с теми страницами и записями, которые действительно опубликованы.

Хороший показатель того, что на сайте правильно настроен robots.txt, .htaccess и добавлены условия для файла function.php, которые запрещают поисковым машинам пускать в индекс дублирующий контент.

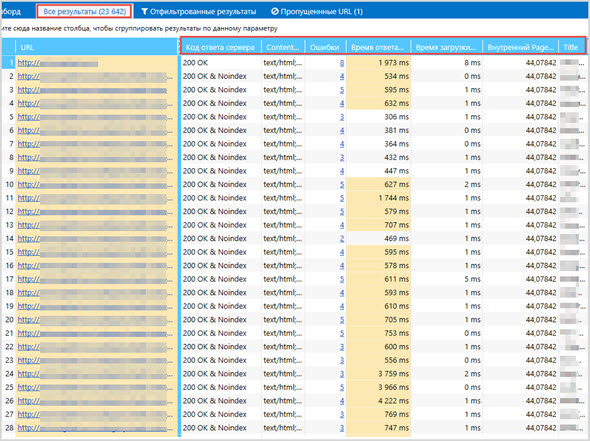

Теперь можем перейти к изучению всей картины сканирования, для этого жмем следующую вкладку «Все результаты», где анализ будет отображен в табличном виде для каждого анализируемого URL.

С данными по каждому из тех параметров, которые вы отмечали перед анализом или в его ходе.

- Код ответа сервера

- Ошибки

- Время загрузки страниц

- Глубина

- Редиректы

- Входящие ссылки

- Исходящие ссылки

- Title

- Description

- Пагинация

- Разметка

- Длина H1 и многие другие

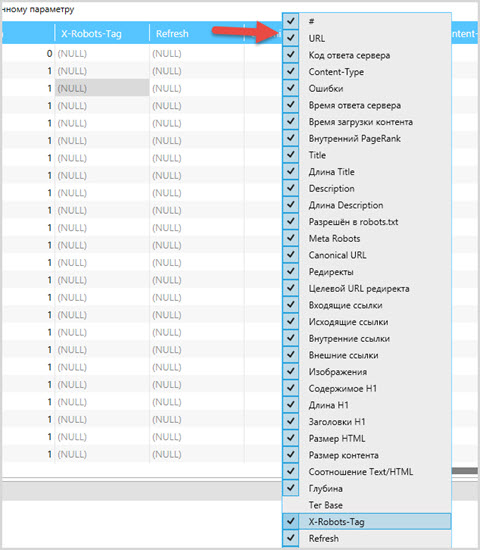

Чтобы немного упростить отчет, можно удалить те параметры, которые были отмечены по ошибки или вам просто эти данные не нужны.

Кликаем правой кнопкой мыши по ячейкам с названием параметров и из выпадающего списка снимаем галочки с ненужных пунктов.

Результаты у нас есть, теперь очень важный момент, это поиск ошибок, думаю 90% вебмастеров и оптимизаторов для этого и будут использовать данный «Паук».

Искать ошибки очень просто, можно это сделать несколькими путями:

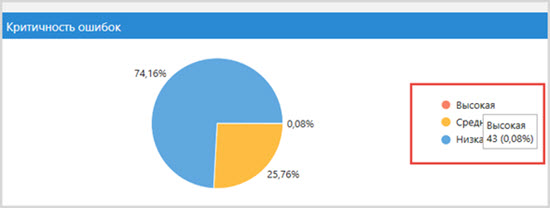

Первое. Перейти через диаграмму «Критичность ошибок», предварительно выбрав их важность.

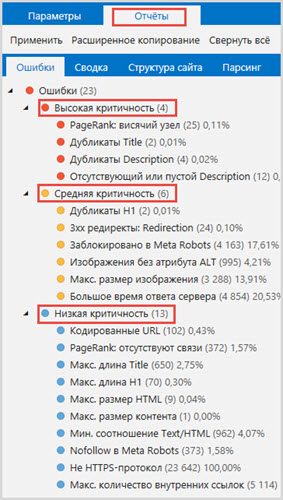

Второе. Через меню «Отчеты», где все имеющиеся ошибки будут представлены в виде дерева.

Мне нравится использовать второй вариант, так как здесь сразу видно, какие именно проблемы на сайте, на каком количестве страниц и в каком процентном соотношении от их общего числа.

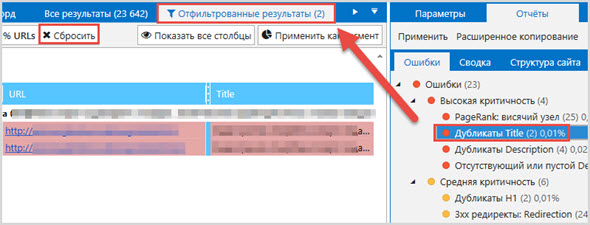

Плюс если выбрать одну из ошибок, в окне слева сразу же будут отфильтрованы результаты по страницам, с конкретным пояснением, что здесь за проблема.

Как видно на анализируемом сайта нашлось 2 страницы, которые имеют одинаковый заголовок.

Аналогичным образом нашлось 4 страницы у которых были одинаковые описания и 12 страницы, у которых тег description вообще не заполнен.

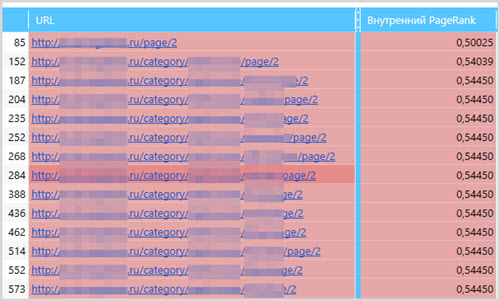

Единственное с чем здесь не согласен так это с ошибками PageRank, так как программа умеет рассчитывать внутренний вес страниц, и она нашла на сайте страницы, на которые ведут ссылки с других постов, а на самих страницах ссылок нет, из-за чего нарушается распределение ссылочного веса.

Только непонятно почему Netpeak Spider придрался к страницам пагинации категорий 2-го уровня?

А так в большей степени нашлись самые распространенные ошибки:

- Дублирующийся Title, H1, Description

- Битые ссылки

- Отсутствующий или незаполненный Description

- Незаполненный атрибут alt у картинок

- Длинные Title и H1

- Большой вес изображений

- Большое время ответа сервера

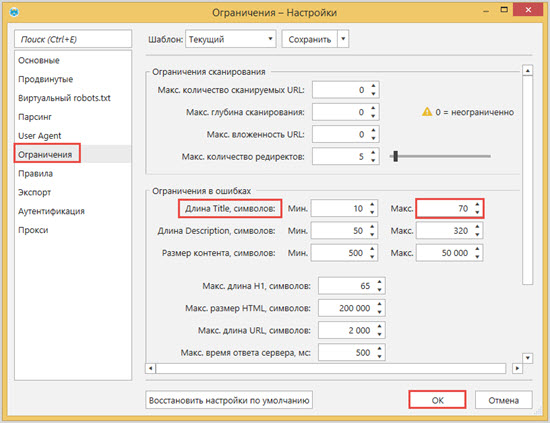

Стоит отметить, что любой из параметров вы можете изменить, то есть указать свои значения, для чего перейдите в настройки «Ограничения».

Например, я считаю, что заголовок у сайта может превышать 70 символов, поэтому данное значение подкорректировал в настройках, чтобы в следующий раз было меньше ошибок.

Еще были ошибки, касающиеся защищенного протокола HTTPS, но это дело каждого переводить на него свои проекты или нет. Лично я все собираюсь это сделать и думаю в ближайшие годы поисковые системы всех заставят если захочешь быть в ТОПе, а пока у меня как всегда руки не доходят. ))

По итогу анализа можно все данные выгрузить в формат .xlsx через кнопку «Экспорт» и продолжить с ними работать вне программы, что тоже удобно.

Полезные инструменты

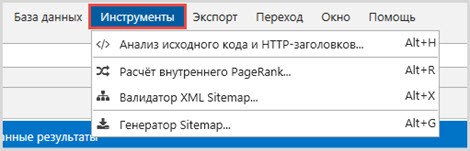

Как вы поняли функций и решаемых задач у Нетпик Спайдер много, но кроме всего прочего софт обладает еще встроенными инструментами:

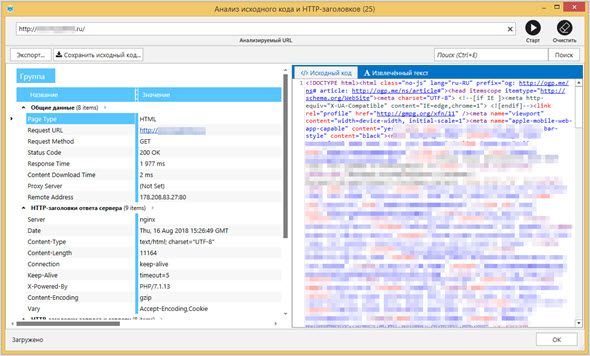

- Анализ исходного кода и HTTP-заголовков

- Расчет внутреннего PageRank

- Валидатор XML-Sitemap

- Генератор Sitemap

Найти их легко, достаточно выбрать соответствующий раздел в верхнем меню.

HTML-код страницы. Здесь чего-то революционного вы не увидите, удобно посмотреть исходный код любой страницы сайта, не покидая программу.

Лично я больше привык это делать через встроенные функции браузера.

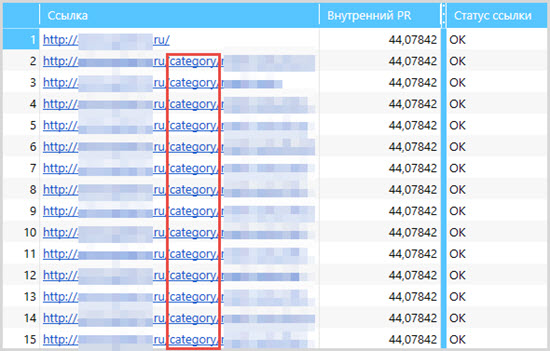

PageRank. А вот этот инструмент мне понравился куда больше, с его помощью можно наглядно увидеть, как на сайте распределяется ссылочный вес, чтобы в будущем его правильно перераспределять и понимать, какие страницы лучше продвигать в поиске.

Благодаря этому на сайте были найдены страницы категорий, которые хоть и имели хороший PageRank, но были закрыты от индексации поисковыми алгоритмами. В будущем имеет смысл привести их в порядок и пустить в индекс, дабы получать еще больше трафика.

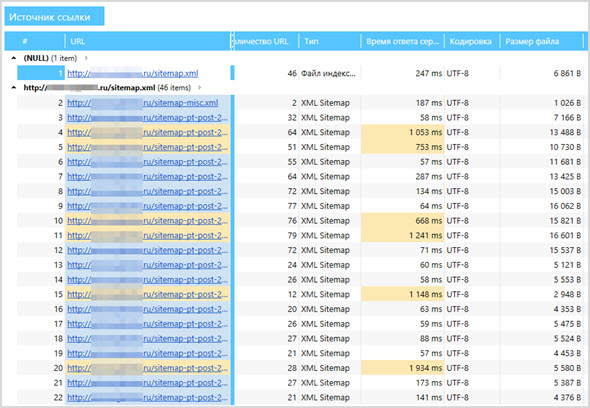

Валидатор Sitemap. Пригодится тем, кто хочет проанализировать существующую карту сайта, с целью выявить ошибки разного уровня критичности. Здесь же можно отправить ping поисковым система, чтобы они проиндексировали ее последнюю версию.

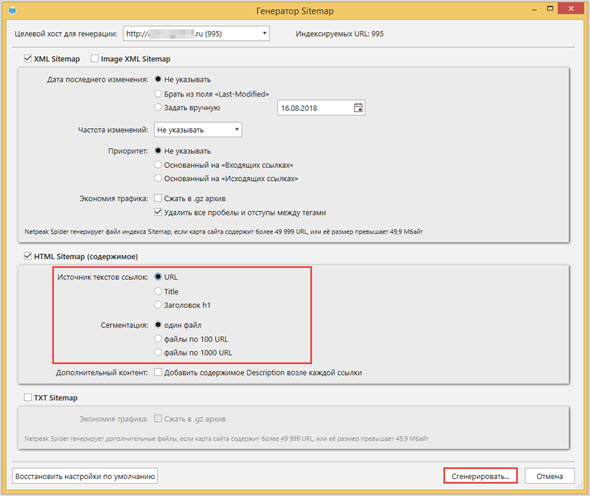

Генератор Sitemap. А для тех, кто только создал сайт и еще не позаботился о файле sitemap можно воспользоваться этим генератором и программ сама все реализует согласно вашим настройкам и правилам поисковиков.

Заключение

Подводя итоги работы с программой Netpeak Spider можно однозначно сказать, что продукт стоящий, понятный и многофункциональный.

Можно было бы поставить 10 баллов, но 1 сниму за то, что все-таки он платный и еще 1 за то, что нет всех функций, которые я бы хотел здесь видеть, например, почему программа не может находить не только битые ссылки, но и битые видео youtube, которых в статьи обычно вставляется очень много и которые со временем перестают работать.

Ранее я испытывал программу конкурент WebSite Auditor, то могу сказать, что здесь Netpeak Spider выигрывает.

Кстати, если вам этот продукт понравится, знайте, что его всегда можно приобрести дешевле. Воспользуйтесь промо-кодом bc8d54de и получите 25% скидку на первую оплату.

Более подробно о продвинутом софте можно почитать на официальном сайте, там же найдете много кейсов и мануалов, как вебмастера находят и устраняют ошибки на своих проектах.

А как вы проверяете свои сайты на предмет ошибок, какие сервисы и программы для этого используете?

Максим, благодарю за качественный и подробный обзор программы! Обязательно воспользуюсь возможность бесплатного теста и проверю свой блог!

![[good] [good]](https://seoslim.ru/wp-content/plugins/qipsmiles/smiles/6.png)

Программа реально хорошая, я много ошибок нашел у себя на сайтах.

Слышал про данную программу, но пока не пробовал. Думаю она стоит того. Почитал отзывы о ней и меня удивило, что многие пользователи не верят подобным программам. Если она определила ошибки, то следует порадоваться, что вы теперь знаете о них и можно все поправить.

Хорошая программа. Плохо только, что тестовый режим такой маленький. Попробую свой сайт проверить.![[good] [good]](https://seoslim.ru/wp-content/plugins/qipsmiles/smiles/6.png)

Спасибо за обзор. Проверю свой сайт. Давно не устранял ошибки, наверно их уже много накопилось.